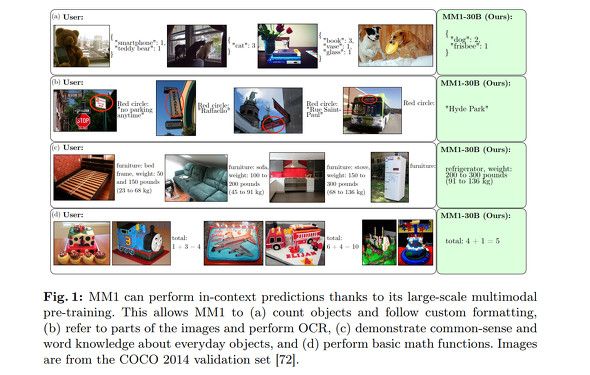

米Appleの研究者らは3月14日(現地時間)、独自開発のマルチモーダルLLM(MLLM)「MM1」の論文を発表した。画像へのキャプション追加や画像とテキストを使った質問への回答、自然言語推論を行えるよう設計したとしている。

MM1は、画像とテキストのペア、画像とテキストの混合データ、テキストのみのデータの混合でトレーニングされている。Mixture-of-Experts(MoE)や教師あり微調整でパラメータを300億までスケールアップすることで、比較的コンパクトなサイズでも競合するMLLMに匹敵する結果をベンチマークで達成したとしている。

視覚タスクでは、米OpenAIの「GPT-4V」や米Googleの「Gemini」に匹敵している。

MM1のアーキテクチャなどは公開されていない。Appleの研究者らは論文の結論を「ここで得られた知見が、コミュニティが特定の単一モデルアーキテクチャやデータ戦略を超えて、強力なモデルを構築するのに役立つことを願っている」と結んだ。

Appleの研究者らは、昨年12月ごろから複数のLLM関連の論文を発表してきた。

Appleのティム・クックCEOは2月の業績発表で、年内にAI分野で進行中の取り組みの詳細を共有すると語った。