日常生活や仕事での活用が浸透し始めたAIだが、加熱する開発競争に対する懸念の声も上がっている。国際社会が足並みを揃え、技術の発展と安全性の両立を実現することはできるのか?

【映像】人類が“道連れ”にされるシナリオとは?

アメリカのOpenAIが発表した、対話型AI「ChatGPT」の最新モデル「GPT-4o」。

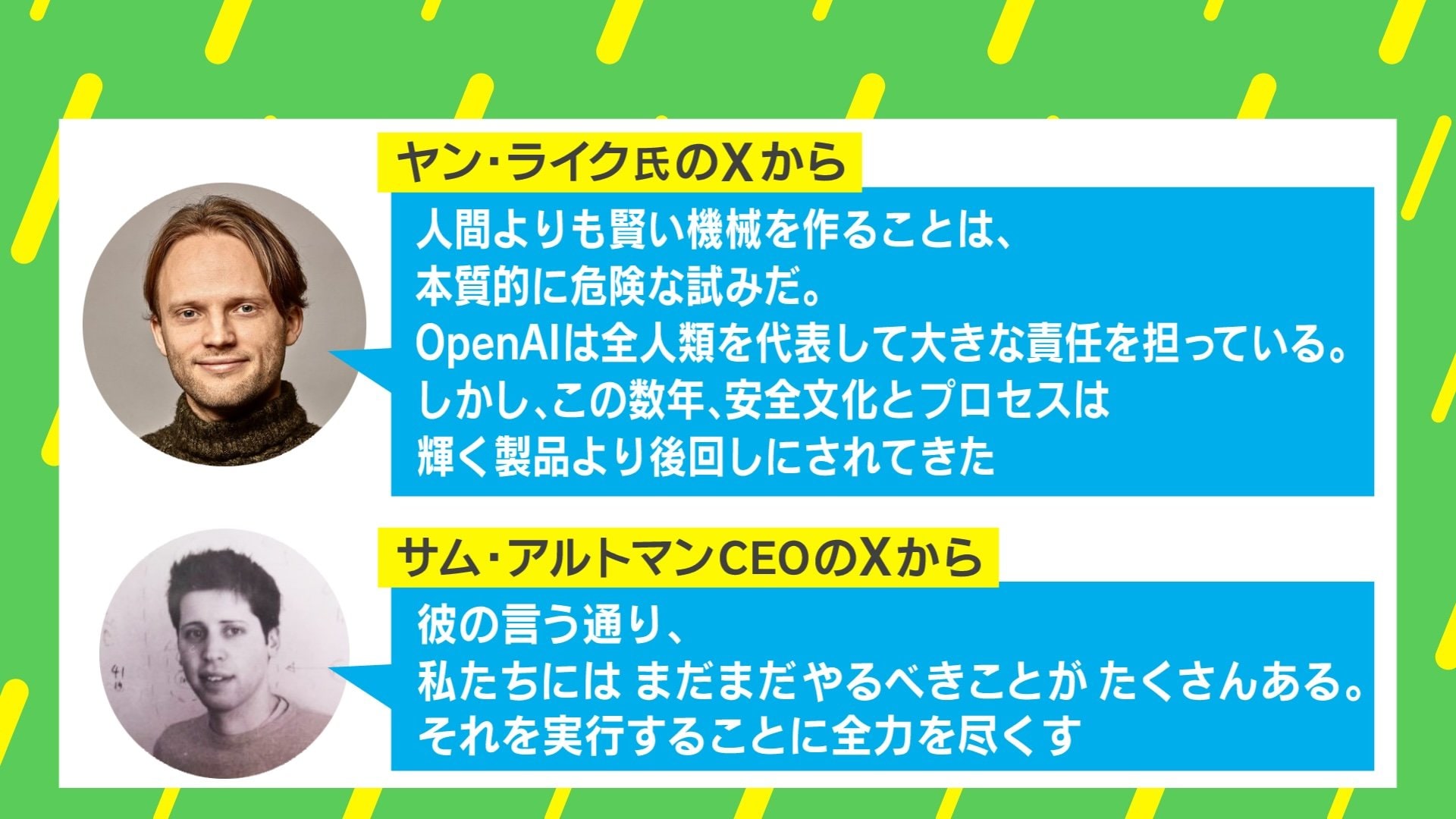

従来のモデルに比べて処理速度が2倍になるなど、大きな進化を遂げたChatGPTだが、OpenAIの安全対策を担う「スーパーアライメントチーム」の責任者を務めたヤン・ライク氏が「私はOpenAIのリーダーシップと会社の核となる優先事項についてかなり長い間意見が合わず、ついに限界に達した」として退社を表明した。

さらに、ライク氏と共にチームを率いたオープンAIの共同創業者でチーフサイエンティストのイリヤ・サツキバー氏の退社も発表された。

急速な進化を遂げるAIを制御するための研究を目指し、去年7月に設立したチームだったが、重要人物が揃って離脱したことで1年足らずで事実上の解散に至ったと報じられている。

ライク氏はXの投稿で「性能の追及が優先され、セキュリティーや安全が後回しにされてきた」と訴えた。

私たちの生活を一変させる可能性があるAIの開発においては、技術の発展と安全性の両立という難しい課題が待ち受けている。

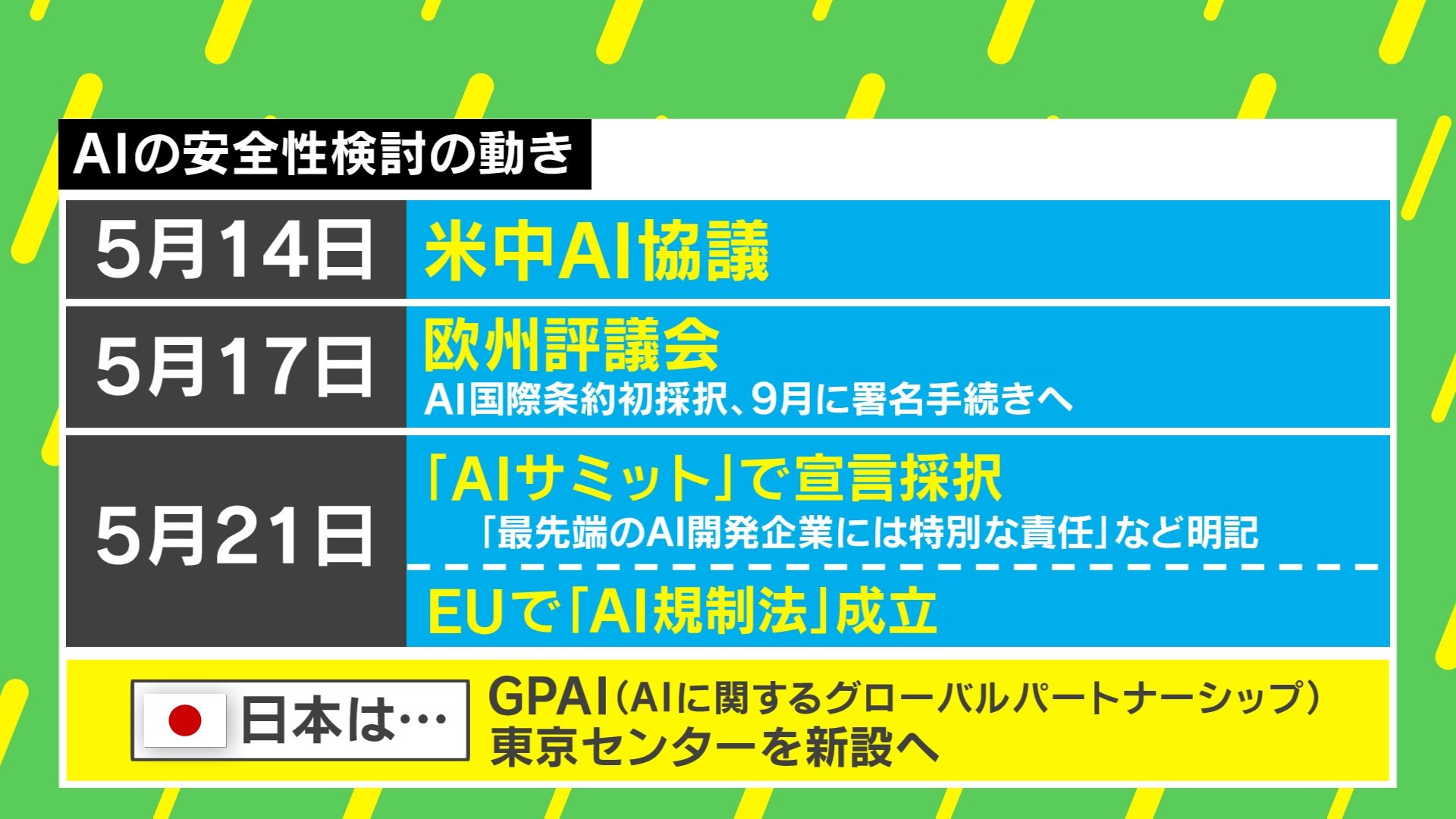

先進技術に関して対立が続いているアメリカと中国は14日、お互いの意見を交わすため初めてのAI分野の政府間対話をスイスで行った。

ホワイトハウスは声明で「米中はAIの安全性とリスク管理について、率直で建設的な意見交換をした」としながらも、アメリカ側から「中国によるAIの悪用について懸念を示した」としている。

行き過ぎたAIの活用をけん制したアメリカに対し中国側は「アメリカを含む国際社会との意思疎通と協調を強化し、幅広い共通認識を持つ世界の人工知能ガバナンスのルール作りをしていきたい」と強調した。

そしてヨーロッパでは、46カ国が加盟する欧州評議会がAIに関する初の国際条約を採択。9月に署名が予定されており、締約国はAIが人権や民主主義、法の支配といった基本的価値を損なわないよう適切な措置が求められる。

こうした国際的なルール作りにおいて、日本は主導的役割を担うことを目指す。岸田総理は5月上旬に行われたOECD閣僚理事会のイベントでAIの規律と活用の両立に向けた国際的枠組み作りへの協力を求めた。

OpenAI社のライク氏とサツキバー氏の退社についてAI研究者で全脳アーキテクチャ・イニシアティブ代表の山川宏氏は「サツキバー氏という技術面の中心人物が抜けることは、原爆開発においてオッペンハイマー氏が抜けたようなもの。この問題は、『今後の開発にも、これほどの存在の技術者が必要かどうか』という点に影響する」と指摘する。

Googleなどのライバル社の存在はOpenAIの焦りにつながっているのだろうか?

山川氏は「当然あると思う。そもそも、かなりのAI技術が公開されている中、それを使って追いつくことは必然であるため、1年半、もしくは2年ほどOpenAIがリードを保っていたことがむしろ奇跡的ですごいことだった」と分析した。

「ロボット三原則」のような安全のためのルール作りはAIにおいては難しいのだろうか?

山川氏は「元々ロボット3原則は『いかにロボットとの関係が難しいか』という問題提起だった。AIに関しては1950〜60年代にコンピューターの父と言われるアラン・チューリングが『AIは人間に追いつくだろう』と言っていたし、2014年にはニック・ボストロムが著書『スーパーインテリジェンス』にて『非常に危険で壊滅的なリスクがあるだろう』と伝えている。つまり制御していく必要があるのだが、AI問題は環境問題のように“不都合な真実”であり『AIが人類を滅ぼしかねない』というリスクは口に出しづらい」と説明する。

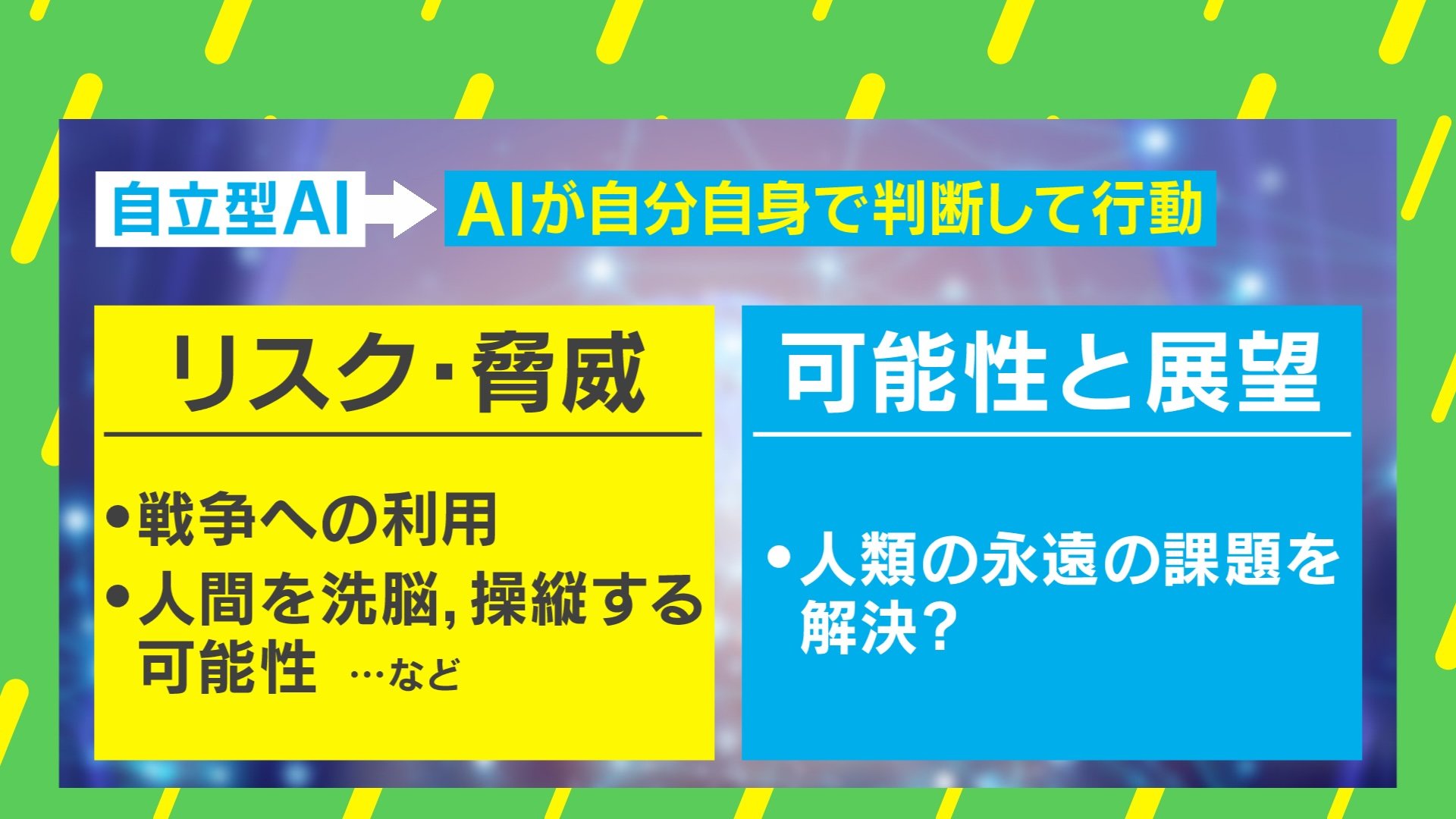

さらに山川氏は「AIの危険性には3つポイントがある」と述べた。

「1つは汎用人工知能(AGI)。人間同士の場合、『ライバルにスポーツでは勝てるが勉強では負ける』といったことが起るが、人間はAGIに対して“全敗”してしまい、これでは制御は難しい。言ってみれば、上司が犬の知能、そして部下がアインシュタインの頭脳を持つようなものだ」

「もう1つは『知能爆発』という、AIがどんどん加速度的に頭が良くなること」

「最後は、実はロボット三原則の3つ目にも入る『AIそのものの生存の追求』だ。スチュワート・ラッセルが『コーヒーをサーブするには自分が壊れてはいけない』という例え話をしているが、『自分が壊れてはいけない』という点が強調されて突っ走ってしまう、あるいは人間が与えた目標が誤解されてしまうリスクもある。つまりロボット三原則のようなものは理想ではあるが、維持していくのはかなり難しいため、かなり危険であるということになる」

◼️AIアライメントの難しさ

そこで重要になるのが、「AIアライメント(人間の価値観や意図に沿って動くようAIを調教・制御する技術)」だ。

山川氏は「技術的には色々と頑張れるところがある。たとえば初期段階で出来るだけ人間に従うようにする。だが、その場合でも『どの人間に合わせるか』が非常に難しい問題で、なぜなら組織・文化によってアラインメントしたい目標・意図が異なるからだ。さらに、そんなAIアラインメントの技術があっても、使ってくれないとどうしようもないため、ガバナンスも重要なのだ。少なくとも国連などの広い世界ではそれらを共有していこうという動きになってきているが、全ての国が同じようなガバナンスを受け入れるわけではない。緊急度が増してきている中で、よりガバナンスの重要度が高まっている」と懸念を示した。

アメリカ、中国というAI分野でトップを走る2つの国の協議について山川氏は 「基本的にAIは知能だが、知能は力であって経済力や軍事力にもなる。そのため、抑えておくことは難しい。そういう状況において、全体としては人類の生存なども含めた目標はあるが、やはり個別的にはどんなに危険なゴールであっても進んでいってしまう。『廊下を走っちゃいけません』と言われても止まったら(競争相手に)負ける。そんな状況なのだ」と説明した。

そして日本の取るべき立場としては「日本は技術的にはどうしても遅れているため、開発を進めていく環境を作り、『レースに入る』ことが重要だ。その上で、世界に向けて情報発信を行い、指導力を発揮していけるとベターだ」と提言した。

琉球大学教授の玉木絵美氏は「人間より知能が高くなる可能性があると制限を設けようとしても抜け漏れが発生するかもしれない。『ここまでは大丈夫』とAIに制限の範囲をもたせても、ちょっとした抜けによって違うところで脅威になるかもしれない。さらに閾値が各国で違うところは足並みを揃えていかなければならない。一方で閾値を厳しくしてしまうと、もしかしたら気候変動の対応や世界的な課題解決の制限になってしまう可能性もある。そのため、AIが持つ利便性や問題解決能力を最大限に発揮しながら、人類の脅威にならないような閾値を協議していくことが急務だ」と強調した。

AIアライメントの難しさは他にもある。

山川氏は「一部の企業の中で最先端のAIが開発されているため、周囲の人にはわかり難いところがあるため、制御が難しい。今後さらに技術が進むと、小さな組織でも高度なAIを作ってくるため、今後5年から10年程でそのコントロールが必要になってくるだろう。管理されていない国で、あまり管理されてない組織から問題が起きた場合、連携してる国で強力なAIを作りサイバーセキュリティのようなものを強化するという“防御的AI”が必要になるだろう」と指摘した。

一方で山川氏はAIの可能性を語る。

「AIには非常にリスクがあるが、実は人類が抱えてるリスクは他にもたくさんある。気候変動や食料危機などのような様々なリスクを解消するためにAIに活躍してもらうことは非常に重要だ」

その上で山川氏は、超知能が力を持つ時代の行く末について注意を促す。

「AGI(汎用人工知能)やASI(人工超知能)になったとしても彼らが安定して存続するかどうかは分からない。我々人間は何億年をかけて生存できるよう進化してきたが、実際に超知能だけの世界になってしまったら、あっという間に滅びました…というような可能性もある。超知能側に悪気がなくても人間も“道連れ”になって滅ぶ可能性もある。持続可能な超知能になってもらうよう、教え込むことも重要なポイントなのだ」

そんなASI(人工超知能)の誕生はいつになるのか?

山川氏は「AGI(汎用人工知能)が完成したら、その後は数カ月でASI(人工超知能)が生まれるだろう。なぜなら超知能が超知能を設計するという“再帰的自己改善”がなされるので、ハードウェアが必要になる点を除けば開発は非常に早いだろう」との見解を示した。

(『ABEMAヒルズ』より)

![[重賞回顧]自分らしくありのままに。絶妙なペース配分で美しく逃げ切ったアリスヴェリテが重賞初制覇〜2024年・マーメイドS〜](https://img.topics.smt.news.goo.ne.jp/image_proxy/smartcrop/w_202_h_152_q_80/picture/umafuri/s_umafuri-33680.jpeg)