Googleはアメリカ時間2024年5月14日、開発者向け年次イベント「Google I/O 2024」を開催。そのオープニングを飾った基調講演の全般的なトーンからは、「もう少し時間がほしい」ことが感じられました。

話題の中心は紛れもなく、Googleが約束していたとおりに改良された人工知能(AI)について。そして、そのほとんどはまだ開発が終わっていません。

しかし、これはさほど驚くことでもありません。Google I/Oは、そもそも開発者向けのイベントですから。

とはいえ、一般ユーザーは「AIと恋に落ちるような時代」まで、もうしばらく待たなくてはならないでしょう。Googleの最新AI機能が一般公開されたら何が期待できるのか、説明していきます。

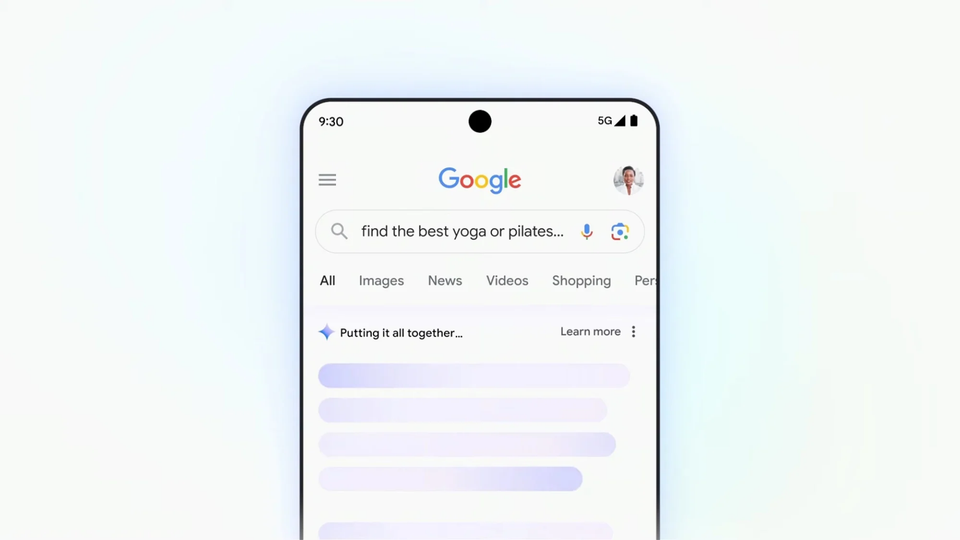

AI活用でGoogle検索もさらに快適に

大半の人にとって、もっともインパクトのある追加機能はおそらく、Google検索へのGemini統合がいっそう進むことかもしれません。

Google検索には、生成AI検索がすでに追加されていて、生成AIがいくつかの段落に要約した検索結果が表示されるようになっています。

近日、ここに仲間入りするのが「AI Overviews」です。

AI Overviewsは、生成AIによる検索結果をページ全体に表示できるオプションのこと。ユーザーの質問に対する回答に加えて、検索の文脈をもとにしたおすすめの情報を提案してくれます。

たとえば、天気の良い日が多い気候に恵まれた場所に住んでいるユーザーが、「近所のレストラン」を検索したとします。するとAI Overviewsは、ベーシックなおすすめレストランだけでなく、テラス席のあるレストランも自発的に表示してくれるかもしれません。

従来の検索結果ページでは、「AIがまとめた検索結果(AI organized search results)」が使えるようになります。一般的なSEOを排除し、きわめて特定されたプロンプトにもとづいて、インテリジェントに検索したウェブページを表示するのです。

たとえばGoogleに、「3日分のグルテンフリーの献立を考えて。野菜をたっぷり使って、デザートは少なくとも2つ入れてほしい」と頼んだとします。すると、検索結果に並んだ各見出しの下に、適切なレシピへと飛ぶリンクが表示されることになります。

アシスタント能力をより強化

さらにGoogleは、検索方法にAIを導入するにあたって、マルチモーダルに重点を置いています。要するに、テキスト以外のものを使って検索できます。

なかでも、開発が進められているのが「Ask with Video」。スマートフォンのカメラを被写体に向けて、「これは何?」とか「どうやって修理するの?」などと音声でたずねると、生成AIが検索して答えてくれる機能です。

ちなみに、「AIが検索した結果は基本的にウェブ上にあるコンテンツの盗用であり、ユーザーが元ソースをクリックすることを省くものだ」という批判がありますが、Googleはこの点について、直接的には言及しませんでした。

Google I/Oに登場したデモンストレーターは、「AI検索機能を使えば便利なリンクを調べることができ、あとはユーザー自身がそれをクリックして確認すればいいのだ」と、何度も強調していました。これは、そうした批判への対応策だったのかもしれません。

AI Overviewsは、実験的な機能を先取りできる、Googleの「Search Labs」ですでに公開されています。

一方、AIがまとめた検索結果とAsk with Videoは、数週間のうちに公開される予定です。

膨大なGoogleフォトから写真を特定

具体的に開発が進んでいる機能には、「Ask Photos」もあります。

マルチモーダルを駆使して、スマートフォンのGoogleフォトに保存されている大量の画像から、お目当てのものを探し出すのに便利な機能です。

たとえば、「昨年、娘がはじめて水泳クラスに参加してプールに入った姿を撮影したが、その写真がどこにあるのかわからない」とします。

「Ask Photos」があれば、「娘が水泳クラスに参加したのはいつ?」とたずねるだけ。すると、スマートフォンは「娘」が誰なのかを自動的に理解し、初めて水泳クラスに参加したときの写真を表示します。

一見すると、「ネコ」と入力するだけで、フォトライブラリに保存されているネコの写真を探してくれる機能と似ています。

けれどもAsk Photosでは、マルチモーダルAIが、より細かい内容の質問に対応し、Geminiとスマートフォンに保存されているデータを駆使して、より広い文脈で質問を理解してアウトプットするのです。

Ask Photosについては、これ以外の詳細はわかっていませんが、数カ月以内に公開される予定です。

ポケットにおさまるサイズのAIエージェント

ここからは、さらに非現実的な夢のような話になります。

「Astra」プロジェクトは、スターウォーズに登場するロボット「C-3PO」にこれまでになく近づいたAIでしょう。

スマートフォンにGeminiアプリを入れ、カメラを開いて周囲に向ければ、そこに映っているものや場面について質問したり、アドバイスを求めたりできるというのですから。

たとえば、スマートフォンのカメラで1台のスピーカーを映すと、どのような部品が使われているのか、どうやって使うのかを、Astraが教えてくれます。

また、手書きで描いた2匹のネコと箱の絵を映して、「この絵から何を思い出す?」と聞くと、「シュレーディンガーの猫ですね」と答えてくれます。

「私がメガネをどこに置き忘れたかわかる?」とたずねる場合、この質問の前にAstraがカメラを通じてメガネを見ていれば、ちゃんと記憶していて置き場所を答えてくれます。

これこそ、昔から夢みられてきたAIだと言えるかもしれません。

そして、OpenAIがアメリカ時間2024年5月13日に発表したGPT-4の最新モデル「GPT-4o」と、とてもよく似ています。そのため、まだリリースできるレベルではないのも仕方がありません。

Astraは「年内投入」が決まっていますが、興味深いことに、スマートフォンだけでなくARメガネでも利用できるようになるそうです。もしかしたら、Googleのウェアラブルデバイスについて、近く発表があるのかもしれません。

AIがホストを務めるポッドキャストを作成

リリース日が不明なこの機能。というのも、大きく宣伝する主要機能というよりは、どちらかというと、進化したGoogle版AIモデルの一例だからでしょう。

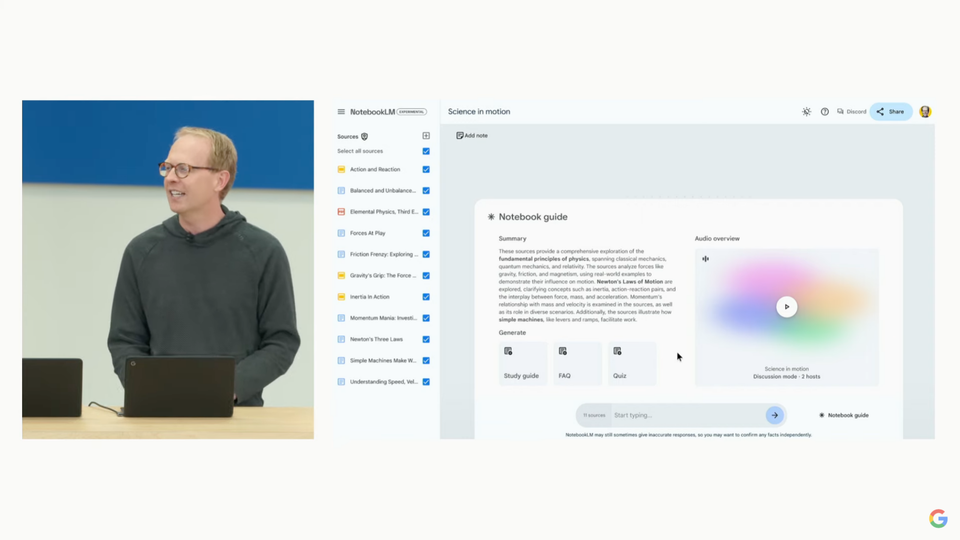

いずれにせよ、Google I/O開催中に行なわれたデモンストレーションのなかで、特に印象に残った(不安に感じた人もいたかもしれない)のが、「AIがホストを務めるポッドキャストをカスタムメイドできる」というものです。

たとえば、学校で物理を学んでいるあなたの息子が、文字を読むより耳で聴く学習方法のほうが向いているとしましょう。

どうやら近いうちに、PDFのテキストをGoogleのノート作成アプリ「NotebookLM」に取り込めば、Geminiに対して、「PDFの内容をもとにしたオーディオプログラムをつくってほしい」と頼めるようになるようです。

つまり、このNotebookLMが、PDFに含まれている内容からポッドキャスト風の番組を生成し、それをAIが自然な感じで読み上げてくれるというのです。

さらに、生徒の側は、ホスト役であるAIの話をいつでも好きなタイミングでさえぎって、「もっとわかりやすく説明してほしい」と頼むこともできるのだとか。

これについてはもちろん、ハルシネーション(AIが生成する真実らしい虚偽の情報)という大きな不安材料がつきまといます。それに、いかにも自然に聞こえる言語は、生理的に嫌な印象があるかもしれません。

それでも、印象に残るデモンストレーションであったのは確かです。いつ実現できるかはわかりませんが。

有料版で利用できる、便利な機能まとめ

ほかにもいくつか、一般ユーザー向けと思われるツールの開発が進んでいます。

とはいえ、現時点ではどれも、GoogleのWorkspace(場合によってはGoogle One AIプレミアム)の有料プラン限定での提供です。

なかでも期待できる機能が、Gmail統合。これには、3つのアプローチがあります。

1つ目は要約で、Gmailのスレッドに最後まで目を通し、重要ポイントを分類してくれるというのですが、これは、さほど目新しいものではありません。2つ目も同様で、メールの内容に応じてAIが文脈に沿った返信を提案してくれる機能。

しかし、3つ目のGeminiを使ったGmail Q&Aは、本当に革新的なようです。

たとえば、屋根工事を検討しているとしましょう。すでに3業者にメールで見積もりを依頼しており、業者別の見積価格と工事可能期間を盛り込んだスプレッドシートを作成したいと考えています。

こんなとき、業者から届いたメール1件1件を細かく確認する必要はありません。Gmailの下部に位置するGemini用の入力欄に「スプレッドシートを作成してほしい」と入力するだけでいいのです。

するとGeminiは、受信トレイ内を検索して、わずか数分でスプレッドシートを作成します。時間を節約できるばかりか、見逃していたメールを発見するのにも役に立ちそうです。

このような文脈を認識したスプレッドシートの作成機能は、Gmail以外のアプリにも導入される予定。さらにGoogleは、Geminiを活用した新しいバーチャルチームメイトについても披露しました。

まだ開発の初期段階ですが、近いうちにWorkspaceに実装される予定です。これはGeminiの典型的なチャットボックスとAstraを掛け合わせて2で割ったような機能と言えるでしょう。

組織独自のSlack風ツールに追加すれば、AIエージェントが、曜日も時間も問わずつねに待機して、質問に答えたり、文書を作成したりするようになります。

Gmail向けGemini機能は5月中に、Workspace Labsのユーザー向けにリリースされる予定です。

Gemsによって関心ごとに分けてチャットを管理

OpenAIは2024年に入ってから、ChatGPTプラグインを終了し、その代わりとなる「GPTs」をリリースしました。これによってユーザーは、ChatGPTチャットボットをカスタマイズして、特定の質問に答えられる特注版をつくれるようになりました。

これに匹敵するのがGoogleのGemsで、仕組みは比較的似ています。

Geminiの自分専用インターフェイス内に、それぞれページをもつGemsをいくつも作成すれば、それぞれのGemsが、特化した指示を実行してくれるのです。

たとえば、Googleのデモンストレーションでは、エクササイズのアドバイスに特化した「Yoga Bestie」というGemsなどが披露されました。

Gemsもまた、リリースまであと数カ月はかかるので、当分はGPTsを使うしかなさそうです。

ピチャイCEOが語る「AIエージェント」への熱意

スマートフォン代わりのデバイスになると謳う米スタートアップ、Humaneのウェアラブルデバイス「AI Pin」とAIガジェット「Rabbit R1」が、消極的な受け止められ方をしてから、まだそれほど経っていません。

ですからAIマニアは、Google I/Oで、これらのデバイスが約束していた機能のGemini版が発表されるのでないかと期待していました。

つまり、ウェブサイトの情報をただまとめるだけではなく、「ウェブサイトと実際に情報をやり取りしてくれるものが登場するのではないか」と考えていたのです。

ところが、思わせぶりな情報が明らかにされただけで、リリース日も決まっていませんでした。

今後に期待

とはいえ、Googleのサンダー・ピチャイ最高経営責任者(CEO)が行なったプレゼンテーションからは、「何歩も先を考えられる」AIエージェントを開発しようとするGoogleの意思が感じられました。

たとえばピチャイ氏は、購入した靴を返品する際に、いずれはGoogleのAIエージェントが手助けしてくれるようになるかもしれないと語っています。

「受信トレイに保存してあるレシートを探す」ところから、「返品フォームに記入」し、「集荷日を予約する」までのすべてを、ユーザーに指示されたAIエージェントが担えるようになる可能性があるというのです。

ただし、これらはみな、デモで示されたわけではないので注意が必要です。あくまでも、Googleが目指す1つのかたちにすぎません。

AIエージェントの話になると、「Geminiが○○できるようになるところを想像してみてください」というセリフが何度も繰り返されました。

Googleの新しいAIモデル

Googleは、具体的な機能を強調すると同時に、新しいAIモデルのリリースと、既存AIモデルのアップデートについても、しきりにアピールしていました。

プレゼンテーションは、「Imagen 3」などの生成AIモデルから、より大型でより文脈に即したGeminiのインテリジェントビルドまで、開発者を対象にした内容でエンドユーザー向けではありません。

動画や音楽などのクリエイティブ領域に期待

しかし、興味深い点もいくつか見受けられました。特に目を引いたのが、動画生成AIツール「Veo」と、音楽生成AIツール「Music AI Sandbox」。

詳細はあまり明かにされませんでしたが、米映画プロデューサーのドナルド・グローヴァー氏や、音楽プロデューサーのワイクリフ・ジョン氏といった有名なクリエーターが「誰もが映画監督になれるでしょう」「このボックスは無限の可能性を秘めています」といった、期待に満ちたコメントをGoogleに寄せていました。

さしあたり、これらの生成AIツールのすごさをよく表しているいくつかのデモ動画が、セレブたちのYouTubeチャンネルに投稿されています。以下は、その1つの例。

開発者向けのLLM新バージョンが登場

Googleがプレゼンテーションでどうしても話題にしたかったのが、AIモデルの「Gemini 1.5 Pro」と「Gemini 1.5 Flash」です。

この2つは、おもに開発者向けのLLM新バージョンで、トークンが増加し、文脈をより正確に理解できるようになります。

一般の人にはあまり関係ないかもしれませんが、「Gemini Advanced」は注目すべきでしょう。Gemini Advancedは、GoogleのGemini有料プランとして、すでに利用可能です。

質問の実行回数が多く、開発者以外でもGemini 1.5 Proとやり取りができるようになっています。Googleドキュメント(Workspace専用機能とは別)といった各種アプリとの統合も可能で、PDFなどのファイルをアップロードすることができます。

Googleが提示した機能の一部は、Gemini Advancedのサブスクリプション契約が必要になりそうです。たとえば、ドキュメントをアップロードしてその内容についてチャットボットに質問したり、それをもとに独自のコンテンツをつくったりしたい場合です。

とはいえ、現時点で機能は何が無料で何が有料になるのか、詳細がわかってません。この点についても、Googleが今回のI/Oで求めた「見守ること」が必要でしょう。

以上が、GoogleがGeminiについて明らかにした発表の概要です。一方でGoogleはさらに、Androidに搭載されるAI新機能の発表も行ないました。

たとえば、「かこって検索(Circle to Search)」の新しい機能や、Geminiを活用した詐欺検知機能といったものです。Android 15については、2024年5月15日にリリースが発表されました。

GoogleのGeminiがリサーチで大活躍! 仕事の「めんどくさい」を任せてラクしよう | ライフハッカー・ジャパン https://www.lifehacker.jp/article/2405-ai-research-gemini/

GeminiがYouTube動画を一瞬で要約してくれるようになった(しかも無料) | ライフハッカー・ジャパン https://www.lifehacker.jp/article/2405-use-gemini-summarize-youtube-videos-free/

Androidスマホにマルを書くだけ。「かこって検索」でさらにスムーズに検索できる! | ライフハッカー・ジャパン https://www.lifehacker.jp/article/2404-how-to-use-google-circle-to-search/

https://www.lifehacker.jp/keyword/ai_business/ 仕事に使える!最新AI記事をチェック

Source: Google, YouTube

![ライフハッカー[日本版]](https://img.topics.smt.news.goo.ne.jp/img/ip_logo/lifehacker_d.gif?150x0)