2022年末のChatGPTの“衝撃”以降、さまざまな企業が生成AIの開発に注力している。ソフトバンクも、英アーム社をはじめ海外企業と協働しながら、開発を進めている。

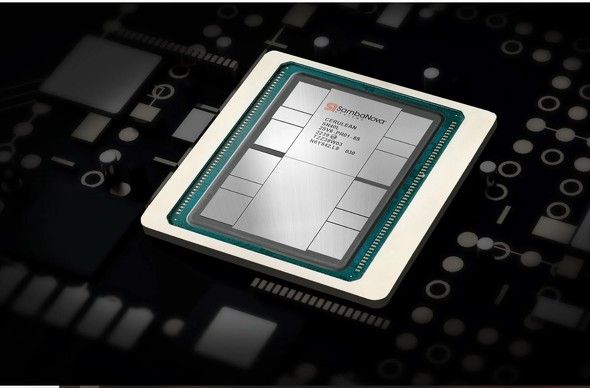

それを支える企業の一つが、米シリコンバレーに拠点を置くSambaNova Systems(サンバノバシステムズ)だ。サンバノバでは、AIに強いプロセッサーを開発しており、市場の大部分を占めるNVIDIA製のチップに代わるものとして期待が集まっている。

特にサンバノバの最新製品「SN40L」は、NVIDIA製の「DGX H100」と比較して28倍低いTCO(総保有コスト、Total Cost of Ownership)を実現し、企業にとって低コスト化を実現するものとしている。

生成AI時代を迎え、企業の課題は何か。生成AIは今後どうなっていくのか。サンバノバ共同創業者のロドリゴ・リアンCEOに聞いた。(河嶌太郎、アイティメディア今野大一)

●「NVIDIA一強体制」を低コスト化で変革 ゲームチェンジャーへ

――いま生成AIが、かつてない流行を見せています。現状を、どう見ていますか。

生成AIの登場は、かつてのインターネットの登場と似ています。インターネットの登場は、世界に大きなインパクトをもたらしたと思います。生成AIの登場も全く同じで、エコシステムの将来の姿だと考えています。

――サンバノバのビジネスモデルについて教えてください。

AIに強いチップの開発・製造・販売をしています。機械学習や深層学習に強いハードの開発だけでなく、ソフト開発環境まで提供しているのが特徴ですね。チップだけを買う企業もありますが、取引先の多くの企業はソフトを含めたシステムを買っています。

――生成AIにおける企業の課題をどう見ていますか。

多くの企業では、機械学習や深層学習など、AIの専門家をなかなか採用できない現実があります。自社で開発するのは難しいので、まずはChatGPTといった既存のものを使おうとするのが現状ではないでしょうか。一方、企業には機密データもあるため、当然ChatGPTにそっくりそのまま全てを移すことはできないわけですよね。

非公開の情報が増えれば増えるほど、ハードの問題だけでなく、システムやソフト、機械学習の問題も生じてきます。サンバノバのソリューションでは、こうしたデータセキュリティーに配慮した生成AIを提供していますので、多くの企業の課題を解決できると考えています。

汎用型のGPTモデルとは異なり、サンバノバでは1社1社にチューニングした固有のモデルを提供できます。そのためプライベートで安全安心に、精度が高い大規模言語モデル(LLM)の提供が可能です。

――今の生成AI市場で、サンバノバはどういったビジネス的なビジョンを持っていますか。

生成AIの将来は非常に広汎な世界になっていくと考えています。まず、われわれが取り組んでいるビジネス側のAIもありますし、ChatGPTのような一般消費者向け、つまりコンシューマー側のAIもあります。どちらも生成AIにおいては、学習が非常に重要になってきます。特にビジネスAIの要件は、コンシューマーAIと比べ、より厳しい要件が必要になってくると考えています。セキュリティーもプライバシーも重要ですし、そして何より精度が重要です。

全ての企業にとって、こうした要件は一つも外してはいけない状況にあると思います。多くの企業にとって、ビジネスAIは今から始まって、これから本番環境を迎える状況だと思います。その際に浮上する課題が、コストの問題です。

実は企業がAIを導入する際、支払っているコストの80〜90%が推論に対するコストなんですね。サンバノバではこのコストを10分の1に減らせると考えています。

――生成AIに使用されるハードは、NVIDIA製品がかなりのシェアを占めています。この現状をどう変えていきますか。

NVIDIAは非常に素晴らしい企業だと思っています。開発環境でもNVIDIAの製品は欠かせません。開発段階から、本番運用段階までまだたどり着いていない企業も少なくないのですが、たどり着いた企業にとっては、NVIDIAを使用することのコストの高さには気が付いているはずです。

そしてソフトの部分にあたる、ChatGPTに代表される製品は、コストが非常に高いと言えます。すでに研究開発から本番運用の段階に到達している企業もありますが、このNVIDIAとChatGPT両方のコストの高さに課題を感じています。

サンバノバの製品は、NVIDIAのチップと互換性を持つのも特徴です。NVIDIAのハードを流用しながら、LLMにあたるChatGPTの部分に、サンバノバのソリューションを使うこともできます。サンバノバではこうしたハード、ソフト両面で製品を提供できますから、企業にとって製品コスト、特に初期の導入コストを大幅に下げられるのです。

●NVIDIA製品よりも低コストにできる理由

――NVIDIAとChatGPT、いずれも導入コストが高くなっている背景には、企業間での競争が本格化していない現状があるのでしょうか。

ChatGPTに代表されるプロダクションは、ちょうど後続のものがたくさん出てきている段階だと思います。これまでの5年間は、比較的ゆっくりな形で製品が研究開発されてきました。これから多くの企業が製品段階に入っていくと、コスト面での競争は避けられないでしょう。

ChatGPT以上に、NVIDIAはもう何年も前から“一強体制”であり、われわれもとても大事なプレーヤーとして非常に高く評価しています。一方ユーザーの中には「サンバノバのソリューションが最高だ」と言ってくださる余地があると確信しています。

その余地は、特にLLMが大きくなればなるほど大きくなると考えています。LLMを運用するためにはスーパーコンピュータをあらゆるところで作るわけですが、その上で費用対効果の考え方は欠かせないと思います。

サンバノバのソリューションでは、本体の価格から消費電力をはじめとするランニングコストまで、非常に効率的にコスト削減が可能です。NVIDIAの製品とも互換性がありますので、さまざまなところでサンバノバの製品にリプレース(代替)できると自負しています。

――なぜサンバノバの製品だと、ここまでのコスト削減が可能なのでしょうか。

SN40Lがわれわれの新製品で、サンバノバの第4世代のチップになっています。特徴は、プロセスノードという設計回路の太さを5ナノメートルへと微細化したことによって、集積トランジスタ数を向上しました。これにより3層のメモリ構造を実現し、広帯域メモリ(HBM)は64ギガバイト、そして大容量メモリ(DDR)は1.5テラバイトを搭載しています。このあたりのチップ環境は、NVIDIAの製品とは大きく異なります。

もともとは画像をリアルタイムで演算するGPUとして開発されたNVIDIAの製品に対し、われわれの製品はRDUと呼ばれる再構成可能なデータフローアーキテクチャを採用し、生成AIで一般的に活用されているLLMなどを処理するのに最適化しています。サンバノバではこうしたハードを単体で提供しているのではなく、ソフトやシステムと統合して管理できる「DataScale」といったラックレベルシステムや、「SambaFlow」というソフト開発ツールも提供しています。

さらに、この統合システムに最適化された事前学習済の基盤モデルを追加した企業向け生成AIプラットフォーム「SambaNova Suite」も提供し、NVIDIAの同等製品「NVIDIA DGX H100」に対し、TCO(Total Cost of Ownership)28倍減という大幅効率化を実現しています。

――既にソフトバンクが開発を進める生成AIにも、サンバノバ製品の採用が決まっています。

ソフトバンクが進めるLLMの基盤(ファウンデーション)モデルにおいて、弊社はパートナーシップを締結しています。この基盤モデルという考え方は、スタンフォード大学で始まったものです。われわれサンバノバは、6年前にスタンフォード大学の関係者を中心に立ち上がりました。当時、基盤モデルを理解する人はほとんどいませんでした。

あれから6年、世界の多くの人たちが基盤モデルを理解し、世界的にも採用され始めてきています。中でもソフトバンクグループという世界でも大手の企業と、基盤モデルでパートナーシップを結べたことを、とてもうれしく思っています。

――日本ではNECが基盤モデルを開発しています。日本市場の可能性についてどう見ていますか。

非常に興奮しています。われわれも日本でこれから頑張っていきたいと思っています。特に、公共レベルと企業レベルの両面で生成AIに対する投資が集まっていることにも期待しています。私は日本のトップ企業の経営者とも話をしていますが、皆さん「この10年間で事業を変革するのはAIだ」とおっしゃっています。私も、こういうメンタリティーが重要だと思っています。

世界には「AIを使うことで、コスト削減ができる」という短期的な目線でAIを見ている人も少なくありません。こうした中、日本のリーダーは長期的、戦略的なものとしてAIを考えています。私はこのように戦略的に考えている人が、最も大きな恩恵をAIから得られると思います。

(河嶌太郎、アイティメディア今野大一)